DeepL und Google AssistantWann kann jeder mit jedem sprechen?

Copyright: KSTA

Die Kölnerinnen und Kölner werden sich über diese Nachricht freuen: Die Aufwertung von Mundarten ist in urbanen Ballungsräumen deutlich zu erkennen. Egal ob in Köln, Hamburg oder München: Lokale Dialekte sind in. Grund dafür ist der Wunsch, sich stärker mit seinem urbanen Lebensraum zu identifizieren. Glokalisierung nennt sich dieses Phänomen.

Ein Kofferwort, das die beiden Wörter Lokalisierung und Globalisierung zusammenführt. Gemeint ist damit der Spannungsbogen von globalen Zusammenhängen und lokalem Handeln. Was ich hier in Köln mache, kann Auswirkungen auf der anderen Seite der Welt haben. Darum ist das, was wir hier in Köln tun wichtig und stiftet Identität.

Diese Ambiguität aus global und lokal zieht sich in den Sprachen weiter fort, denn je größer die Weltbevölkerung wird, desto weniger Sprachen gibt es. Aktuell gibt es 7000 aktive Sprachen weltweit, das sind 500 Sprachen weniger als im Jahr 1500. Und das wird auch weiterhin abnehmen, sagen Anthropologen. Im Jahr 2200 sollen es nur noch 100 aktive Sprachen sein. Das Deutsche kommt aber gut weg: Schon heute befindet sich das Deutsche mit über 120 Millionen Sprechenden unter den zehn meistgesprochenen Sprachen. In der Wissenschaft steht Deutsch sogar auf Platz zwei.

Die deutsche Angst, die Sprache löse sich in andere Sprachen auf, ist also ungerechtfertigt: Die übrig gebliebenen Sprachen werden immer komplexer und umfangreicher.

Für uns Sprechende ist die Notwendigkeit, mindestens zweisprachig aufzuwachsen aufgrund der Globalisierung immer größer geworden. Abhilfe geloben da digitale Assistenten, die wir jederzeit verfügbar mit unseren Smartphones herumtragen. Schnell mal etwas übersetzen? Kein Problem dank Siri und Google Translate. Mittlerweile bieten Alexa und Co sogar Dolmetscherservices an. Wird der aktiviert, können sich zwei Menschen, die die Sprache des anderen nicht verstehen, so unterhalten, als wäre ein Dolmetscher dabei. Bis irgendjemand Stopp sagt.

Das könnte Sie auch interessieren:

Möglich wurde das aufgrund eines Paradigmenwechsels, weiß Samuel Läubli, der an der Universität Zürich Machine Learning lehrt und mit TextShuttle sein eigenes Übersetzungs-Start-up betreibt. Während am Anfang der maschinellen Übersetzung quasi wortweise übersetzt wurde, war es ab 2014 aufgrund des technischen Fortschritts möglich „Natural Language Processing“ durchzuführen und ganze Sätze zu interpretieren. Was zuvor wie ein wild durcheinandergeworfener Wortsalat anmutete, bekam plötzlich sprachliche Struktur, was besonders auch an Redewendungen zu bemerken war.

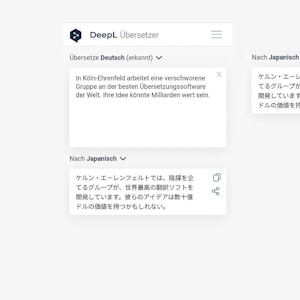

Diesen Durchbruch machte sich zum Beispiel das damals in Köln ansässige Start-up Linguee zunutze und setzte alles daran, den besten Übersetzungsdienst der Welt zu bauen. Mit Erfolg. Das mittlerweile unter dem Namen DeepL bekannte Start-up gehört zu den 100 meistbesuchten Webseiten und beschäftigt über 200 Mitarbeiter.

DeepL vor Google Translate

DeepL hat Google Translate als führenden Übersetzungsservice abgelöst. Warum Läubli mit seinem Start-up nicht wie DeepL ebenfalls einen kostenlosen Service anbiete, erklärt er mit den horrenden Kosten. „DeepL verschenkt da ziemlich viel Rechenpower und monetarisiert das dann später mit Firmenkunden.“ Läublis Start-up verdient selbst an Firmenkunden. „Wir machen im Grunde das Gleiche wie DeepL.“

Während man früher vor allem viele Trainingsdaten benötigte, sei es heute wichtig saubere Daten zu bekommen, so der CTO. Denn sonst imitiere der Algorithmus die Fehler.

DeepL hat das vor allem mit Native Speakern gemacht, wie ein Blick auf LinkedIn zeigt. In den frühen Jahren arbeiteten Dutzende Native Speaker für die damals noch kleine Firma im Mediapark, um die maschinell erzeugten Übersetzungen zu überprüfen. Das ging so weit, dass es Teamleiter für die Übersetzungsteams gab, die mit Absicht Fehler einbauten, um die Übersetzer zu testen, sagt ein ehemaliger Angestellter gegenüber der Redaktion.

Auch wenn der Schritt von Googles ersten Übersetzungsversuchen von 2007 bis heute beträchtlich ist: Von einem Babel-Fisch sind wir noch immer weit entfernt. Ein Babelfisch ist ein kleines Fischchen, das sich die Protagonisten in Douglas Adams’ Roman „Per Anhalter durch die Galaxis“ ins Ohr stecken, damit die übersetzte Sprache des Gegenüber wie aus dessen Munde klingt und zu den Lippenbewegungen passt.

Fans von Star Trek kennen diese Technologie als kleines Gadget, „Communicator“ genannt, den die Raumfahrer an ihrer Uniform tragen. „Und das dauert auch noch Jahrzehnte“, weiß der Voice-Assistant-Experte Robert Mendez. Mendez gründete mit aufkommendem Voice-Hype eine eigene Agentur in Frechen, veranstaltete eine Voice Konferenz in Köln und hat sogar ein Buch über Voice-Assistenten in der Schublade liegen.

„Tal der Tränen“

„In Bezug auf die Assistenten befinden wir uns gerade in einem Tal der Tränen. Denn in den letzten fünf Jahren hat sich nicht wirklich etwas getan. Obwohl man nach immer mehr Dingen fragen kann, fehlt es noch immer an Tiefe. Von einem wirklichen Dialog oder neuen Anwendungsfällen sind wir immer noch weit entfernt.“ Dabei haben Konzerne wie Facebook viel in die Sprachassistenten investiert und den Hype damit befeuert. Den größten Zugewinn sieht Mendez in der Barrierefreiheit. Gerade nicht sehende Menschen könnten durch Voice-Assistenten einen beträchtlichen Zugewinn an Lebensqualität erleben, erklärt er.

Müssen wir also erst auf den nächsten technologischen Quantensprung warten? Vielleicht kann uns eine über einhundert Jahre alte Erfindung weiterhelfen. Im Jahre 1887 veröffentlichte ein Augenarzt unter dessen Pseudonym „Doktoro Esperanto“ eine Plansprache mit dem Ziel, Ghettobildung und Rassismus zu verhindern.

Esperanto ist eine Sprache, die leicht zu lernen ist, keinem Staat zugerechnet werden kann und damit den Sprecher unpolitisch und neutral wirken lässt. Beste Voraussetzungen also, eine international anerkannte Sprache zu werden.

Und in der Tat ist Esperanto so beliebt wie noch nie: Sie ist mit über eine Millionen Sprechenden die größte Plansprache der Welt. Tendenz steigend. Auf Wikipedia besetzt sie mit 300.000 Artikeln den 36. Platz, auf Twitter ist Esperanto auf Platz 30.

Translaton von Google

Auch wenn Esperanto einen steten Zugewinn verzeichnen kann: Vielleicht macht dann doch der technische Fortschritt das Rennen: Im Mai 2019 stellte Google den Translatotron vor. Dieser neuartige Ansatz geht dabei nicht erst den Umweg über das geschriebene Wort, sondern vergleicht direkt die Aufzeichnung eines Satzes, der in verschiedenen Sprachen gesprochen wurde.

Mit erstaunlichen Ergebnissen: Der synthetisierte Satz klingt nicht nur umgangssprachlicher. Aufgrund fortgeschrittener Sprachsynthese klingt der Satz sogar wie der Native Speaker, nur eben in der anderen Sprache.

Noch war das nur ein Experiment von Google. Aber vielleicht bekommen wir demnächst einen Service, in dem wir den CEO von Google Sundar Pichai in geschmeidigem Kölsch zu hören bekommen. Ganz im Sinne der Glokalisierung.